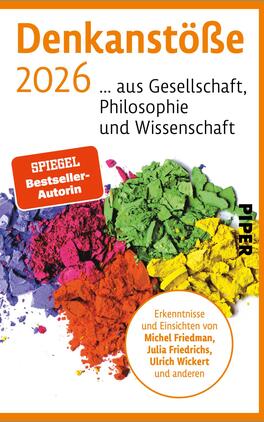

Produktbilder zum Buch

Denkanstöße 2026 (Denkanstöße)

Für einen direkten Kontakt und Fragen zum Produkt wenden Sie sich bitte an:

info@piper.de

Piper Verlag GmbH

Georgenstraße 4

80799 München

Beschreibung

„Eine wertvolle Orientierungshilfe.“ FAZ Online

„Sie haben wenig Zeit, wollen aber trotzdem viel wissen? Die ›Denkanstöße‹ fassen die wichtigsten Erkenntnisse zusammen.“ SPIEGEL ONLINE

Die „Denkanstöße 2026“ – das sind ausgereifte Argumente, kompaktes Wissen und spannende Positionen eines ganzen Jahres. So schreibt der Publizist Michel Friedmann über Antisemitismus und Demokratiefeindlichkeit und darüber, wie verhindert werden kann, dass Hass und Gewalt gegen Juden weiter zunehmen. Die Reporterin Julia Friedrichs fragt, wie viel Ungleichheit eine Gemeinschaft verträgt und ob Reichtum Grenzen…

„Eine wertvolle Orientierungshilfe.“ FAZ Online

„Sie haben wenig Zeit, wollen aber trotzdem viel wissen? Die ›Denkanstöße‹ fassen die wichtigsten Erkenntnisse zusammen.“ SPIEGEL ONLINE

Die „Denkanstöße 2026“ – das sind ausgereifte Argumente, kompaktes Wissen und spannende Positionen eines ganzen Jahres. So schreibt der Publizist Michel Friedmann über Antisemitismus und Demokratiefeindlichkeit und darüber, wie verhindert werden kann, dass Hass und Gewalt gegen Juden weiter zunehmen. Die Reporterin Julia Friedrichs fragt, wie viel Ungleichheit eine Gemeinschaft verträgt und ob Reichtum Grenzen braucht, und der Journalist Ulrich Wickert beleuchtet die Geschichte der Europäischen Union und wirbt für ein friedliches, starkes Europa.

Ein Lesebuch zum Mit- und Weiterdenken!

Weitere Titel der Serie „Denkanstöße“

Aus „Denkanstöße 2026 (Denkanstöße)“

Vorwort

Wir leben in einem Zeitalter der Krisen und Chancen, der Neuerungen und des Umbruchs. Gewiss, auch in früheren Zeiten haben vermutlich schon viele so gedacht. Und dennoch bleibt der Eindruck, dass die Geschwindigkeit, in der sich die aktuellen Veränderungen vollziehen, höher ist als je zuvor. Mehrere wichtige Bereiche unseres Lebens verändern sich gleichzeitig immer schneller. Die Künstliche Intelligenz – die gerade erst in unser Arbeits- und Alltagsleben getreten ist – wird immer leistungsfähiger, und es wird immer einfacher, auf Informationen zuzugreifen.

D [...]

Vorwort

Erkenntnisse aus Philosophie und Wissenschaft

Michael Schmidt-Salomon Die Evolution des Denkens – Das moderne Weltbild – und wem wir es verdanken

Ein Kopf denkt nie allein

Die größten Genies aller Zeiten?

Der Zukunft entgegen

Die Menschheit im Anthropozän

Planetare Verantwortung

Die neue Achsenzeit

Karsten Brensing Die Magie der Gemeinschaft – Was uns mit Tieren und künstlichen Intelligenzen verbindet

Das Sozialleben, die Triebfeder des Geistes

Die Magie der Gemeinschaft

Gemeinsam sind wir stark

Die Erfindung der Lüge, und warum wir trotzdem vertrauen

Freundschaft und Allianzen

Christina Pingel DIAGNOSE: FRAU – Wie mich die männerbasierte Medizin fast das Leben kostete

Mutter und Tochter

Die Untersuchung

Die Diagnose

Erfahrungen aus Politik und Wirtschaft

Julia Friedrichs CRAZY RICH – DIE GEHEIME WELT DER SUPERREICHEN

Wenn aus Reichtum Macht wird

Mohamed Amjahid Alles nur Einzelfälle? – Das System hinter der Polizeigewalt

Eine kleine Geschichte der Polizei

Deutsche Police Academy

Jeannette zu Fürstenberg, Inge Kloepfer Wie gut wir sind, zeigt sich in Krisenzeiten – Ein Weckruf

Mindset

Der menschliche Faktor

Einsichten aus Gesellschaft und Zeitgeschehen

Michel Friedman Judenhass – 7. Oktober 2023

Wieder

Versprochen. Gebrochen

Wo seid ihr?

Brief an die Gleichgültigen

Scherben

Daniel Goffart, Angelika Melcher Boomer gegen Zoomer – Der neue Generationenkonflikt und wie wir uns besser verstehen können

Prägung – Wie wir wurden, was wir sind

„Cancel Culture“ – der neue Kulturkampf um das „Unsagbare“

Ulrich Wickert Salut les amis – Meine Geschichte der deutsch-französischen Beziehungen

Die Schatten der Vergangenheit

Beziehungskrise – Trennung von Problemen, nicht vom Partner

Autorinnen und Autoren

Quellen und Anmerkungen

Die erste Bewertung schreiben